Magazine PROF n°9

Dossier PISA n’est pas le bulletin des enseignants

Un thermomètre à prendre pour ce qu’il est

Article publié le 01 / 03 / 2011.

Léger mieux en compréhension de l’écrit, stagnation à la baisse en cultures mathématique et scientifique. Qu’y a-t-il derrière ce résumé de PISA 2009 en Communauté française ? Que dit cette enquête de notre système scolaire ? Des performances des élèves ? De l’efficacité du travail en classe ? De sa qualité ? Douze pages d’analyse, pour vous aider à en juger.

Des questionnaires top secret, des élèves soustraits de leurs classes pour y répondre sous la conduite d’un examinateur extérieur, des écoles tirées au sort, une correction loin des regards des équipes pédagogiques puis, plus d’un an et demi après, un battage médiatique d’une semaine centré sur quelques chiffres clés et sur un classement entre des pays et régions du monde aussi diverses que le Monténégro, Shangai, le Qatar, le Pérou, la Corée ou la Communauté française de Belgique. La pointe de l’iceberg PISA, c’est ça. Et elle alimente les fantasmes.

« L’enquête PISA détermine dans quelle mesure les élèves qui arrivent en fin d’obligation scolaire ont acquis certaines des connaissances et compétences essentielles pour pouvoir participer pleinement à la vie de nos sociétés modernes, en particulier en compréhension de l’écrit, en mathématiques et en sciences » (1). Cette orientation, critiquée par ceux qui y voient une aliénation de l’éducation à l’économie, implique qu’on n’y évalue pas « la faculté des élèves à reproduire ce qu’ils ont appris, mais [que PISA] vise surtout à déterminer dans quelle mesure ils sont capables de se livrer à des extrapolations à partir de ce qu’ils ont appris » (2).

Pour les professionnels de l’enseignement que vous êtes, c’est plus qu’une nuance : PISA ne mesure pas le « rendement scolaire » et ne peut donc être vu comme le bulletin des enseignants ! Qui ont raison d’affirmer, en, réplique aux ritournelles obsessionnelles des thuriféraires de PISA, que l’enseignement, c’est bien plus et bien autre chose que cette version standardisée de la compréhension de l’écrit et des cultures mathématique et scientifique, sorte d’esperanto universel garantissant une place (de choix ?) dans l’eldorado mondialisé.

Pour autant, peut-on jeter PISA avec l’eau du bain ? Évidemment non. Simplement, ce thermomètre est à prendre pour ce qu’il est : très rigoureux (lire ci-dessous), et destiné non pas à évaluer le travail en classe, mais à orienter les politiques éducatives qui, elles, influenceront les pratiques enseignantes. C’est d’ailleurs l’hypothèse qui prévaut en Communauté française pour expliquer les progrès observés entre 2000 et 2009 en lecture.

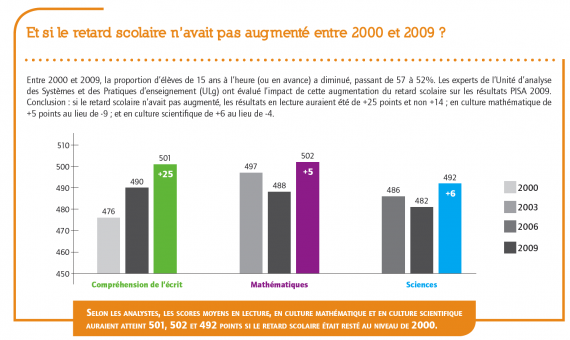

Un progrès équivalent à un tiers d’année scolaire

Car il y a progrès, même s’il faut se garder de tout triomphalisme : en lecture, alors que la moyenne internationale a faibli (de 500 en 2000 à 493 en 2009), celle des élèves de la Communauté française a progressé de 14 points, passant de 476 à 490. Le progrès se note surtout entre 2006 et 2009 : + 17 points (de 473 à 490), un écart statistiquement significatif et qui correspond à « plus ou moins un tiers d’année scolaire » (3), selon la Pre Dominique Lafontaine, qui dirige l’Unité d’analyse des systèmes et des pratiques d'enseignement, à l’ULg (4).

En culture mathématique, la moyenne en Communauté française (488) se situe légèrement sous les moyennes OCDÉ (496) et européenne (491). Comme on le verra plus en détail en pages 21 et 22, la différence filles-garçons, au profit de ceux-ci, est importante : 25 points contre 12 en moyenne OCDÉ. Enfin, avec 15 et 19 points de moins que les moyennes européenne et OCDÉ, la situation est moins avantageuse pour la culture scientifique, même si la légère baisse enregistrée entre 2006 et 2009 (de 486 à 482) équivaut à celle de la moyenne européenne (500 à 497).

Des écarts entre élèves dans tous les pays

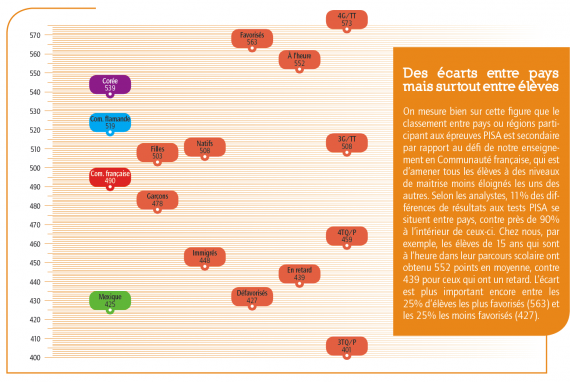

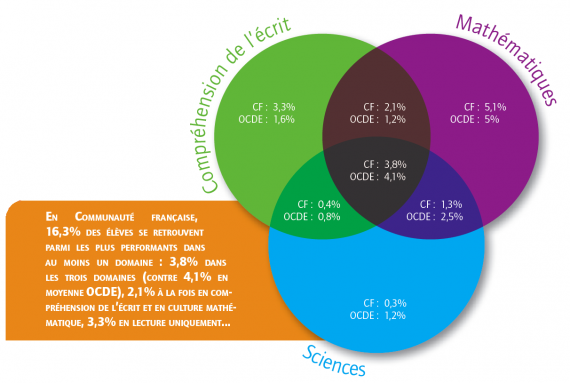

Ces scores permettent de nous situer ou d’élaborer des hypothèses quant aux performances des uns et des autres, mais il convient de relativiser : « Les écarts entre les pays ne représentent toutefois qu’une partie de la variation globale de la performance des élèves. Répondre aux besoins d’un effectif d’élèves d’une telle diversité et combler les écarts de performance qui s’observent entre eux reste un énorme défi dans tous les pays » (5). Selon la Pre Lafontaine, « 11% des différences de résultats se situent entre pays, contre près de 90% à l’intérieur de ceux-ci ». Et on voit bien sur la figure ci-jointe les écarts entre « nos » élèves.

Sur ce terrain, PISA 2009 confirme ce qu’on savait déjà : alors que les scores moyens observés en Communauté française sont inférieurs aux moyennes OCDÉ, flamande et germanophone, l’écart entre les 25% d’élèves les plus faibles et les 25% d’élèves les plus forts est systématiquement plus grand, comme l’indique la figure ci-contre. Et c’est là toute l’ambivalence des résultats de nos élèves : hormis en culture scientifique, les 25% d’élèves les plus forts obtiennent à PISA 2009 des scores supérieurs à la moyenne OCDÉ. Et même significativement supérieurs pour ce qui est de la compréhension de l’écrit. Mais entre les plus forts et les plus faibles, les écarts de plus de 150 points équivalent, selon les analystes, à plus de quatre années d’étude !

En outre, si l’on croise les résultats des élèves avec des données individuelles ou liées aux écoles qu’ils fréquentent, la Communauté française présente également des écarts considérables : 136 points entre les plus et les moins favorisés socioéconomiquement ; 151 points entre les 25% d’écoles les plus fortes et les 25% d’écoles les plus faibles. On peut se réjouir que 37 des 110 écoles testées (qui scolarisent 40% des 3102 élèves de l’échantillon) dépassent en lecture les scores moyens de la Corée et de la Finlande. Et que la moitié des élèves soient dans des écoles ayant un score supérieur à la moyenne OCDÉ. Mais il est difficile de passer sous silence que les 25% d’écoles les plus faibles cumulent les difficultés : niveau socioéconomique plus faible, moins de dix livres à la maison, près de 50% d’élèves immigrés et de 80% d’élèves en retard.

Trop d’élèves faibles, mais pas de nivellement par le bas

Depuis l’électrochoc de PISA 2000, l’objectif que s’est assignée la Communauté française consiste à améliorer les résultats des élèves les plus faibles. En compréhension de l’écrit, une partie du chemin a d’ailleurs été faite : la proportion d’élèves les plus faibles a diminué de 5% alors qu’en moyenne OCDÉ, elle a crû d’1%. À l’inverse, la proportion de très bons lecteurs a augmenté de 2% alors qu’elle a régressé d’autant en moyenne OCDÉ. Il n’en reste pas moins que « la Communauté française reste parmi les systèmes éducatifs des pays industrialisés qui comptent la plus grande proportion d’élèves faibles » (6), soit 23%, juste avant… le Mexique.

Une autre façon de mesurer le chemin parcouru (toujours en lecture) consiste à observer quelles catégories d’élèves progressent. Filles et garçons le font, mais les unes de 8 points, les autres de 18. L’écart au profit des premières est désormais l’un des dix plus faibles parmi les 74 pays ou régions examinées (26 points contre 39 en moyenne). Évolution encourageante aussi quand on compare les résultats des élèves d’origine belge (+13 points) et issus de l’immigration (+39), même si ces derniers affichent un score moyen plus faible (448 contre 508). En outre, ces progrès ne se sont pas faits au détriment des meilleurs élèves, qui ont aussi amélioré leurs résultats en lecture.

Comment expliquer cette amélioration ? Tant la ministre de l’Enseignement obligatoire que les responsables de l’Administration de l’Enseignement et de la Recherche scientifique et la Pre Lafontaine y voient le résultat d’une mobilisation générale. « La convergence des référentiels de compétence, des programmes, des outils d’évaluation, a progressivement mené le monde de l’école à une autre approche de la lecture », indiquait la ministre Simonet lors de la présentation des résultats PISA 2009. « Ce travail de qualité, en profondeur et dans la durée, associant tous les partenaires, institutionnels et de terrain, porte aujourd’hui ses fruits. Même si la modestie reste de mise, ces résultats sont de nature à restaurer la confiance, principalement chez tous les acteurs de terrain ».

Cette mobilisation générale semble avoir produit des effets auprès des jeunes eux-mêmes. Les questionnaires personnels remplis par les 3109 élèves de 15 ans après l’épreuve elle-même permettent de dégager notamment un indice d’attitudes positives envers la lecture et un indice relatif à la diversité des textes lus. Sur ces deux plans, la situation s’améliore en Communauté française, se rapprochant de la moyenne OCDÉ, et ce sont surtout les garçons (traditionnellement plus faibles en lecture) qui ont progressé chez nous. Et l’équipe de la Pre Lafontaine de conclure que « la lecture-compréhension a sans doute été LE chantier des années 2000-2010 » (7). Pourra-t-on en dire de même pour les maths en 2010-2020 ?

(1) OCDÉ (2011), Résultats du PISA 2009 : Savoirs et savoir-faire des élèves – Performance des élèves en compréhension de l’écrit, en mathématiques et en sciences (Volume I), p. 18. http://dx.doi.org/10.1787/9789264097643-fr

(2) Ibidem

(3) Selon la façon très complexe d’apprécier la « valeur ajoutée » d’une année d’études, les analystes la font correspondre à un écart de 30 à 40 points sur l’échelle PISA. Dans ce dossier, nous avons opté pour 40 points.

(4) BAYE A. et al, La lecture à 15 ans. Premiers résultats de PISA 2009, dans Les Cahiers des Sciences de l’Éducation, n°31, Unité d’analyse des systèmes et des pratiques d’enseignement (aSPe), Université de Liège, 2010, p. 12.

http://www.enseignement.be/download.php?do_id=7697

(5) OCDÉ (2011), Résultats du PISA 2009, p.13.

(6) BAYE A. et al, op.cit., p. 12.

(7) Id., p. 17.

Trois ans de préparation pour deux heures d’épreuve

PISA (Programme International pour le Suivi des Acquis des élèves) est un cycle d’enquêtes mené par la Direction de l’Éducation de l’Organisation de coopération et de développement économiques. Les 34 pays membres de l’OCDÉ ainsi que 41 pays et/ou économies partenaires y ont participé en 2009. Il concerne la compréhension de l’écrit, la culture mathématique et la culture scientifique des élèves de 15 ans (quelle que soit leur année d’études), avec chaque fois un domaine « majeur » (en 2012, la culture mathématique).

Objectif principal : mesurer comment les jeunes maitrisent « certaines connaissances et compétences essentielles » (1). L’évaluation « ne se fonde pas sur les curriculums nationaux. Ce ne sont pas les compétences effectivement enseignées dans les classes qui sont évaluées mais des compétences jugées essentielles pour la vie future des jeunes » (2).

Pré-test. Après la conception de l’épreuve et les traductions/adaptations des questions, un pré-test permet notamment de sélectionner les questions les plus pertinentes. Chez nous, il a concerné près de 700 élèves, en 2008. Des 213 questions de lecture, 98 furent conservées !

Treize carnets de test. Ces 98 questions de lecture avaient trait à 29 textes, formant autant d’unités. Répondre à toutes prendrait 6 h 30. Elles ont été réparties dans 13 carnets de tests différents, de façon que chaque unité apparaisse dans 4 carnets, en début, au milieu, ou en fin de carnet. Cela assure la validité de la mesure des domaines évalués, et annule l’effet « fatigue ».

L’échantillonnage est validé par un organisme indépendant. Chaque pays doit pouvoir justifier sa méthode 3 109 élèves de 110 établissements formaient « notre » échantillon comptant par exemple 9,4% d’élèves en 4e TQ ou P et 21,2% en 3e TQ ou P, alors qu’ils sont 10 et 21,1% dans la réalité : des marges statistiquement insignifiantes. Cet échantillon a été défini en deux étapes :

1. Les écoles sont réparties en douze groupes, selon trois critères (réseau, ordinaire/spécialisé, alternance) puis classées dans chaque groupe selon deux critères (taille et taux de redoublement). Par tirage au sort, 110 écoles sont choisies. Les directions sont prévenues après la sélection.

2. Chaque école communique la liste de ses élèves de 15 ans, et un logiciel en sélectionne aléatoirement 35 (tous s’il y en avait moins de 35).

Le jour J, sous la houlette d’un administrateur extérieur, les élèves ont deux heures pour répondre à plusieurs séries de questions associées à des supports différents (article, graphique, schéma,…) et aussi authentiques que possible. Environ 45% des questions sont ouvertes, 55% fermées (type QCM).

Correction. Les questions à choix multiple sont encodées par des personnes formées, les questions ouvertes corrigées par des enseignants de la discipline, eux aussi formés. Ils attribuent un code à la réponse sur base d’une grille de correction. La correction est soumise à plusieurs contrôles.

Questionnaire de situation. Les élèves remplissent aussi un questionnaire permettant de définir des indices de motivation/engagement en lecture, ou de connaissance des stratégies efficaces, et de les mettre ensuite en relation avec les résultats . Il permet aussi des corrélations entre résultats et variables individuelles ou entre écoles, les chefs d’établissement répondant également à un questionnaire sur l’organisation de l’école.

Résultats. Depuis décembre 2010, l’OCDÉ publie résultats, analyses et base de données, ce qui permet des analyses complémentaires par tout chercheur intéressé. Chaque école « testée » reçoit son résultat. Les résultats individuels ne sont pas transmis…

(1) BAYE A. et al., La lecture à 15 ans. Premiers résultats de PISA 2009, dans Les Cahiers des Sciences de l’Éducation, n°31, Unité d’analyse des systèmes et des pratiques d’enseignement (aSPe), Université de Liège, 2010, p. 1 à 5. http://www.enseignement.be/index.php?page=25160

(2) Ibidem

Moteur de recherche

Tous les dossiers

Retrouvez également tous les dossiers de PROF regroupés en une seule page !